וקטורים ואמבדינג – הקדמה

כדי לנהל מערכות בינה מלאכותית בארגון, יש להבין את המנגנון המתמטי שמפעיל אותן. מודלים מתקדמים אינם מבינים שפה כפי שבני אדם מבינים אותה; הם מתרגמים טקסט למערכות מספרים הנקראות וקטורים (Vectors) בתהליך שנקרא אמבדינג (Embedding).

אז מה זה בעצם אמבדינג ווקטורים?

מודלים של שפה לא מבינים שפה כמו בני אדם. במקום זאת, הם ממירים מילים וחלקי מילים (טוקנים) לייצוגים מתמטיים שנקראים וקטורים.

- וקטור = מערך של מספרים במרחב רב-ממדי.

- כל מילה מומרת לוקטור שמייצג אותה גם מבחינת משמעות וגם מבחינת הקשר תחבירי.

- תהליך ההמרה הזה נקרא אמבדינג (Embedding).

וקטורים: הכתובת של המילים על המפה

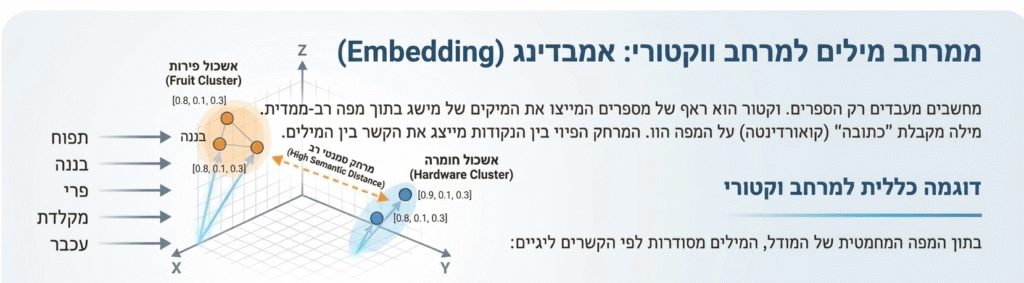

מחשבים מעבדים רק מספרים. וקטור הוא רצף של מספרים המייצג את המיקום של מושג בתוך מפה רב-ממדית. דמיינו מפה עם אלפי צירים שונים. כל מילה מקבלת “כתובת” (קואורדינטה) על המפה הזו. המרחק הפיזי בין הנקודות מייצג את הקשר בין המילים:

דוגמה כללית למרחב וקטורי

בתוך המפה המתמטית של המודל, המילים מסודרות לפי הקשרים לוגיים:

- מילים באותה “שכונה”: המילים “תפוח”, “בננה” ו-“פרי” יקבלו כתובות קרובות מאוד. אם תכתבו בטעות “תפןח”, המודל יראה שהנקודה הזו נמצאת בלב שכונת הפירות ויסיק מיד שמדובר בתפוח.

- מילים בשכונות מרוחקות: המילה “תפוח” והמילה “מקלדת” ימוקמו בנקודות רחוקות מאוד במרחב. למרות ששתיהן עצמים פיזיים, אין ביניהן קשר סמנטי (משמעותי) רציף.

אמבדינג: איך נוצרת המפה?

אמבדינג הוא התהליך שבו המודל לומד היכן למקם כל מילה על המפה. במהלך שלב הלמידה, המערכת סורקת כמויות אדירות של טקסט ומזהה אילו מילים נוטות להופיע יחד. היא מחשבת את הזיקה הסטטיסטית ביניהן ויוצרת את המפה בהתאם.

כאשר משתמש מקליד “חןרף” (עם טעות הקלדה), המודל הופך את הרצף הזה לווקטור. מכיוון שהרצף הזה דומה מאוד למילה “חורף”, הכתובת שלו על המפה תהיה כמעט זהה למילה הנכונה. המודל פשוט ניגש לכתובת הקרובה ביותר ומסיק מה הייתה הכוונה. זהו תהליך של אופטימיזציה מתמטית, לא “הבנה” אנושית.

וקטורים, אמבדינג ופרדוקס ה”הבנה” במודלי שפה

כאשר אנחנו מדברים על “הבנה” של בינה מלאכותית, אנחנו למעשה מתארים תהליך גאומטרי מתקדם. המודל אינו מחזיק בתודעה או בניסיון חיים; הוא מחזיק במפה של קשרים סטטיסטיים המיוצגים באמצעות וקטורים ואמבדינג.

ההבדל בין משמעות למיקום במרחב

עבור בני אדם, למילה יש משמעות מופשטת המבוססת על הקשר רגשי, ערכי או ניסיון חיים. עבור מודלי שפה מתקדמים, המילה היא פשוט “כתובת” (וקטור) הממוקמת על מפה מתמטית.

תהליך ה-Embedding יוצר “שכונות” של מושגים על בסיס קשרים סטטיסטיים:

- שמות של פירות כמו “תפוח” ו-“בננה” יקבלו כתובות קרובות מאוד במרחב הווקטורי.

- מושגים שאינם קשורים, כמו “תפוח” ו-“מקלדת”, ימוקמו במרחקים גדולים, מה שמונע מהמודל לקשר ביניהם בטעות.

מדוע קרבה אינה הבנה? למשל במקרה של שגיאת כתיב “חןרף”.

המודל יודע לגשר על שגיאות כתיב (כמו “חןרף” במקום “חורף”) לא כי הוא “מבין” שהמשתמש טעה, אלא כי המתמטיקה מראה שהווקטור של המילה השגויה נוחת בלב השכונה של המילה הנכונה.

ניהול סיכונים ובקרת איכות

הסיכון האסטרטגי טמון בכך שהמודל אינו יודע מהו המהות של האובייקט. הוא יודע שהמילה “תפוח” מופיעה סטטיסטית ליד “אדום” או “עץ”, אך הוא אינו מבין את ההקשר הפיזי או הביולוגי. בניהול נתונים, המשמעות היא שהמודל פועל על בסיס דמיון צורני וסטטיסטי, מה שעלול להוביל לטעויות כאשר קיימים מושגים דומים עם השלכות חוקיות או פיננסיות שונות.

ההסתמכות על סטטיסטיקה מחייבת אותנו להגדיר בקרות לפי רמת הסיכון של המשימה:

משימות בסיכון נמוך

הגדרה: חיפוש סמנטי במסמכי פנים, סיווג פניות לקוחות, סיכום פרוטוקולים.

בקרת איכות: איסוף משוב מהמשתמשים (Feedback loops). טעות קלה במיקום הווקטור לא תגרום לנזק עסקי משמעותי.

משימות בסיכון גבוה

הגדרה: ניתוח דוחות כספיים, השוואת חוזים, קבלת החלטות מבוססת נתונים רגישים.

בקרת איכות: חובה להשתמש בשיטת Grounding (אימות מול מקור מידע חיצוני) ובקרה אנושית בתהליך. במשימות אלו, דמיון סטטיסטי בין שני וקטורים שונים עלול להוביל למידע שגוי עם משמעות גדולה.

ערך עסקי ושימוש במשאבים

הבנת המנגנון מאפשרת לארגון לפעול ביעילות בכמה רבדים:

- אופטימיזציה של נתונים: המודל מסוגל להתגבר על נתונים לא נקיים (שגיאות כתיב, ניסוחים שונים) מבלי להשקיע משאבים בניקוי ידני של בסיסי הנתונים.

- חיפוש חכם: היכולת למצוא מידע לפי משמעות ולא לפי מילת חיפוש מדויקת מייצרת יעילות תפעולית גבוהה.

- דיוק בביצוע המשימה: task definition (הגדרת המשימה) מדויקת מאפשרת למודל למצוא את הוקטורים הנכונים ביותר עבור המטרות העסקיות שלכם.

וקטורים ואמבדינג – שורה תחתונה :💡

מודלי שפה הם מחשבונים מתקדמים של הסתברות. המילים הן הנתונים, והוקטורים הם הדרך שבה המודל מנווט ביניהם. הכרה במגבלות הסטטיסטיקה היא המפתח לשמירה על Data Integrity ולמיצוי הערך העסקי של הטכנולוגיה בארגון.

מדריך להבנת טוקנים, וקטורים ואמבדינגים ב־LLMs by shlomi oved

שאלות ותשובות: וקטורים, אמבדינג וניהול נתונים

מה זה בעצם וקטור (Vector) בהקשר של בינה מלאכותית?

תחשבו על וקטור כעל “כתובת דיגיטלית”. במקום לשמור מילה כאוסף של אותיות, המודל מתרגם אותה לסדרה ארוכה של מספרים. המספרים האלו מגדירים את המיקום המדויק של המילה על מפה רב-ממדית ענקית. המיקום לא נקבע לפי האותיות, אלא לפי המשמעות וההקשר שבו המילה מופיעה בדרך כלל.

מה זה אמבדינג (Embedding) ואיך הוא קשור לווקטורים?

אמבדינג הוא התהליך הטכני שבו המערכת הופכת את הטקסט לווקטור. המודל סורק כמויות אדירות של מידע ולומד אילו מילים נוטות להופיע יחד. על בסיס הלמידה הזו, הוא “נוטע” (Embed) כל מילה בנקודה מסוימת במרחב. ככל ששני מושגים קרובים יותר במשמעות שלהם, כך האמבדינג שלהם ייצור וקטורים עם כתובות קרובות יותר על המפה.

האם המודל באמת מבין את מה שהוא כותב?

לא. מדובר במערכת סטטיסטית מתקדמת בלבד. עבור המודל, מילים הן קואורדינטות מתמטיות. הוא לא “יודע” מה זה קור, הוא רק יודע שהווקטור של “חורף” מופיע סטטיסטית ליד הווקטור של “סוודר”. היכולת שלו לייצר טקסט רהוט נובעת מחישוב של המילה הבאה שהכי סביר שתופיע בהתבסס על המיקומים במרחב.

מהן המגבלות של הגישה הווקטורית בניהול נתונים ארגוניים?

הסיכון העיקרי הוא “הזיות סטטיסטיות”. מאחר והמודל עובד לפי קרבה, הוא עלול לבלבל בין שני מושגים שדומים בכתיב שלהם אך שונים לחלוטין במשמעות העסקית (למשל, שני מוצרים עם שמות דומים). לכן, אי אפשר להסתמך על המודל בעיניים עצומות במשימות קריטיות מבלי להוסיף שכבות של אימות נתונים.