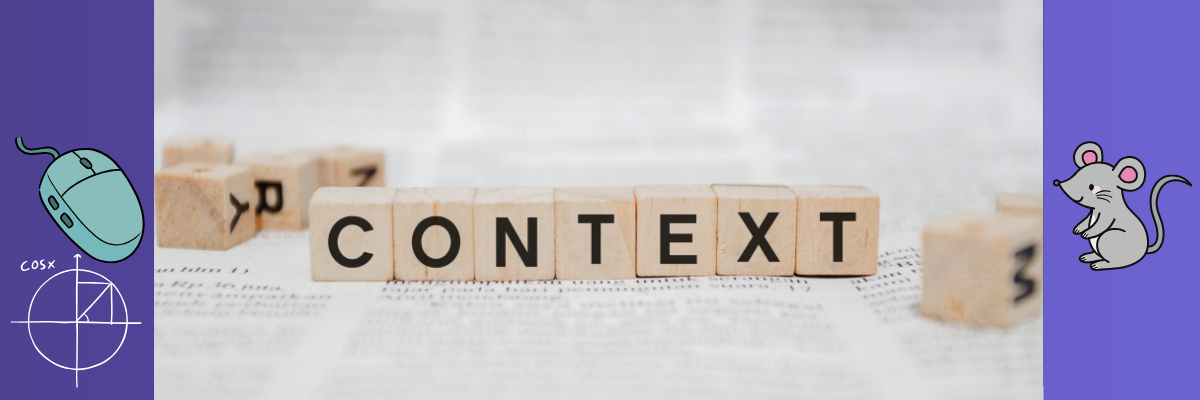

עכבר זה לא תמיד עכבר 💡

והמאמר הזה הוא בדיוק על זה – על איך AI לומד להבין הקשר.

כדי להמחיש את הדוגמה:

- החתול רדף אחרי העכבר 🐭

- קיבלתי עכבר חדש למחשב 🖱️

זאת בדיוק אותה מילה, אבל ברור שהמשמעות שונה לחלוטין.

אז איך המודל יודע את זה?

מודלים מתקדמים כמו GPT לא מקצים וקטור קבוע לכל מילה

במקום זה – הם מחשבים וקטור חדש לפי ההקשר.

תהליך זה נקרא: Contextual Embeddings

כלומר, הטבעה דינמית שמבוססת על המילים שנמצאות לפני ואחרי.

וקטור דינמי – תלוי הקשר

| הקשר | משמעות | שכנות וקטורית |

|---|---|---|

| “החתול רדף אחרי העכבר” | 🐭 חיה | קרוב ל: חתול, מכרסם |

| “עכבר חדש למחשב” | 🖱️ מכשיר | קרוב ל: מקלדת, מחשב, חומרה |

איך זה עובד בפועל?📐

- המודל מחשב את הקוסינוס בין הווקטור של “עכבר” למילים סביבו.

- אם הזווית קטנה – המשמעות קרובה.

- כל הקשר מייצר תוצאה אחרת.

למה זה חשוב ❓

✔ דיוק גבוה יותר

✔ זיהוי רב-משמעות

✔ התאמה לתחום/שאלה/כוונה

שורה תחתונה 💡

הייחוד של GPT ודומיו הוא היכולת לזהות הקשר ולהתאים משמעות.

המילה “עכבר” לא מקבלת תגית אחת – אלא מקבלת וקטור חדש, בהתאם למשפט.

וזה בדיוק מה שמאפשר לבינה מלאכותית להישמע חכמה באמת.

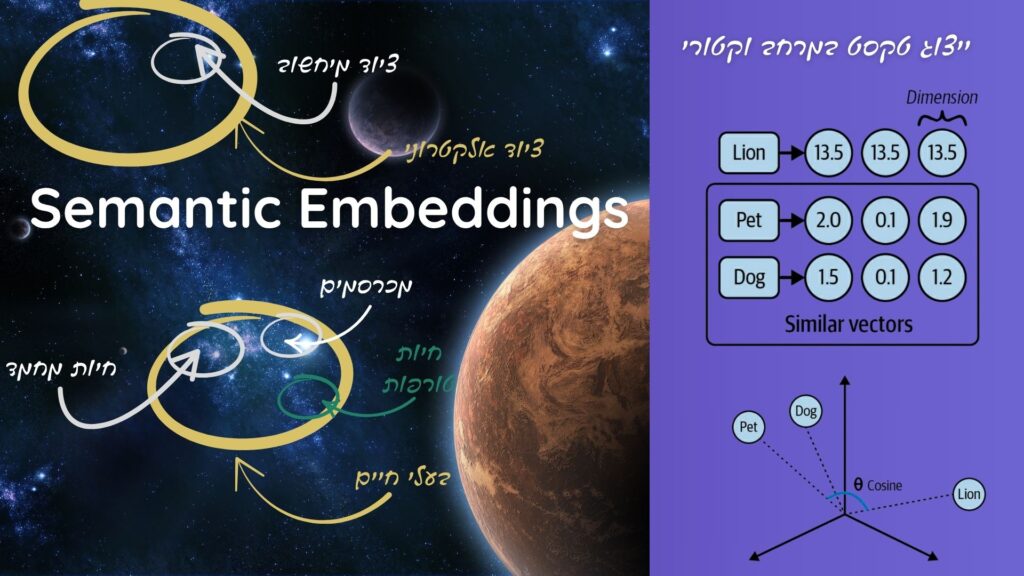

אז איך כל זה נראה בפועל? ✨

התמונה הבאה מדגימה בצורה ויזואלית איך מודל שפה “חושב” – כלומר, איך הוא ממקם מילים במרחב מתמטי לפי המשמעות שלהן.

מילים עם קשר סמנטי כמו “כלב” ו”חיית מחמד” יהיו קרובות, ומילים רחוקות במשמעות – רחוקות גם במרחב.

תחשבו על זה כמו גלקסיה של משמעויות, שבה כל מילה היא כוכב, וכל קבוצה של מושגים יוצרת מערכת משלה.